Weltuntergangsszenario: Wenn die KI sich selbst konsumiert

Dass KI-Modelle sich mit synthetischen Daten selbst trainieren, könnte dramatische Folgen haben. Wissenschaftler zeichnen ein (Web-)Weltuntergangsszenario.

Forscher der Rice Universität in Houston, Texas, sind der Frage nachgegangen, was passiert, wenn KI sich selbst trainiert.

Und die Ergebnisse geben Grund zur Sorge: Das Training aufeinanderfolgender Generationen generativer KI-Modelle mit synthetischen Daten könnte zu Rückkopplungsschleifen führen, bei denen die KI sich gewissermassen «selbst konsumiert».

Die grosse Herausforderung: Engpässe bei Trainingsmaterial

Modelle wie OpenAI's GPT-4o oder Stability AI's Stable Diffusion sind überraschend gut in der Lage, neue Texte, Codes, Bilder und Videos zu erstellen.

Für das Training dieser Modelle sind jedoch so grosse Datenmengen nötig, dass Entwickler schon jetzt an Versorgungsengpässe stossen. Die letzten Ressourcen könnten bald vollständig ausgeschöpft sein – und dann?!.

Synthetische Daten: Verführerisch, aber gefährlich

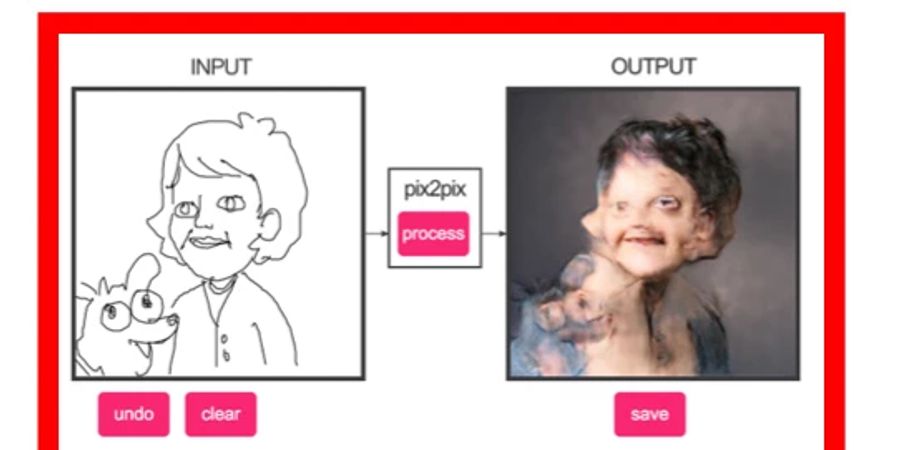

Unter diesen Umständen scheint es nur konsequent, beim Training zukünftiger KI auf sogenannte synthetische Daten zurückzugreifen, heisst: solche Daten, die nicht aus dem realen Leben stammen, sondern von der generativen KI selbst erzeugt wurden.

Die Vorteile lägen klar auf der Hand: Synthetische Daten sind kostengünstiger als reale Daten und nahezu unbegrenzt verfügbar. Das Datenschutzrisiko ist geringer bis gleich null, und in einigen Fällen können synthetische Daten die Leistungsfähigkeit der KI sogar verbessern.

Jüngste Daten der Forschergruppe aus Houston lassen jedoch den Schluss zu, dass ein Training mit synthetischen Daten negative Auswirkungen auf zukünftige generative KI-Modelle haben könnte.

Wenn die KI sich selber «frisst»

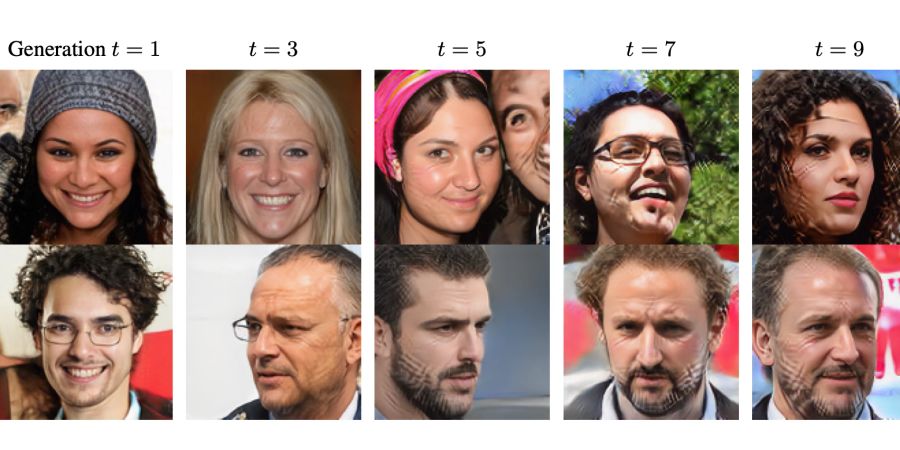

Eine konkrete Gefahr bestünde in der sogenannten «Rückkopplungsschleife». Diese entstünde da, so die Forscher, wo das synthetische Training von KI-Modellen laufend wiederholt würde: eine Art «autophager» oder «sich selbst konsumierender» Dynamik, die in einem «Modellkollaps» münden könne.

Mehr noch: Nach einigen Generationen des Trainings mit synthetischen Daten können neue KI-Modelle so für immer beschädigt werden. Ein Phänomen, für das die Forscher der Houston-Universität nun den Begriff «Modell-Autophagie-Störung» (MAD) einführen.

Die «MAD-ness», also «Verrücktheit» oder ein «Wahnsinn», klingt in dem Wort so bewusst wie gewollt mit.

Vorgang könnte das gesamte Internet vergiften

Würde sich diese MAD-Störung über Generationen hinweg per KI entfalten, seien irgendwann die Datenqualität und -quantität des gesamten Internets vergiftet: das ein Weltuntergangszenario der involvierten Forscher.

Unvermeidlich schiene schon jetzt, dass die KI-Autophagie bereits in naher Zukunft bisher nicht absehbare unbeabsichtigte Folgen hat.

Viel mehr noch als bisher gilt also: Wo möglich, machen Sie den Faktencheck, wo Daten aus dem Internet Quellen für Ihr Denken und Ihr Handeln werden sollen!